阿里巴巴开源:一次采集轻松解决多摄像机和3D激光雷达标定

点云PCL免费知识星球,点云论文速读。

文章:Single-Shot is Enough: Panoramic Infrastructure Based Calibration of Multiple Cameras and 3D LiDARs

作者:Chuan Fang1 , Shuai Ding, Zilong Dong, Honghua Li, Siyu Zhu, Ping Tan

编译:点云PCL

代码:https://github.com/alibaba/multiple-cameras-and-3D-LiDARs-extrinsic-calibration.git

来源:arxiv 2021

欢迎各位加入免费知识星球,获取PDF论文,欢迎转发朋友圈。文章仅做学术分享,如有侵权联系删文。未经博主同意请勿擅自转载。

公众号致力于分享点云处理,SLAM,三维视觉,高精地图相关的文章与技术,欢迎各位加入我们,一起每交流一起进步,有兴趣的可联系微信:920177957。本文来自点云PCL博主的分享,未经作者允许请勿转载,欢迎各位同学积极分享和交流。

摘要

多个相机和3D激光雷达的集成已成为增强现实设备、机器人和自动驾驶车辆的基本配置,多模态传感器的校准对于系统正常运行至关重要,但对于大规模生产来说,它仍然是不切实际的,此外,大多数设备在使用一段时间后需要重新校准,在本文中,我们提出了一种单次采集的解决方案,用于校准多个相机和三维激光雷达之间的外参。在此建立了一个全景标定间,在这个标定房间中,可以使用单帧数据对相机或激光雷达进行可靠定位,在三台具有不同相机激光雷达配置的设备上进行的实验表明,该方法实现了与最先进方法相当的标定精度,并且效率更高!!!

主要贡献

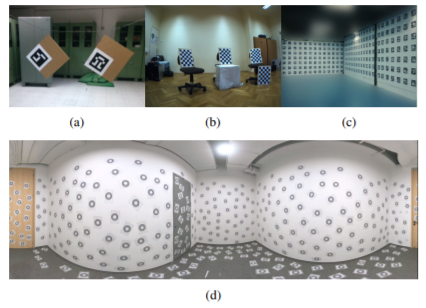

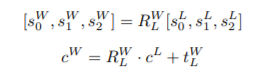

图1:规模不断扩大的各种标定间。(a) 基于纸板的标定场景,(b)基于棋盘格的标定间,(c)基于AprilTag的标定间,以及(d)本文提出的的全景标定间

图1a显示了用于相机与激光雷标定的两块硬纸板的方法,为了同时校准多个传感器,研究人员提出了大规模封闭场景设备,其关键目的是将来自多个传感器的数据匹配到一个共同的场景中,该场景设施应该足够大,可以覆盖所有传感器的视图。图1b显示了具有多个棋盘格的封闭场景,而图1c显示了中包含了由数百个AprilTags覆盖的三个平面墙,然而,这两个基础设施并不是全景式的,这意味着只能同时校准系统的一部分,因此,耗时的多次捕获是不可避免的。

为了克服多次采集场景的限制,本文提出了一种全景校准标定场景。如图1d所示,这样的标定间是一个720度的房间,由分段的平面墙和地板组成,并由无特征的基准标记覆盖。实验证明,无特征基准标记在校准精度方面略优于Apriltag,此类型标定间具有以下特点:

全景式,720度场景与多模态系统中所有传感器的视觉重叠,因此仅从单个姿势捕获一次就足以将所有传感器定位标定间坐标系下。

鲁棒性,随机分布的无特征基准标记物和分段平面的直线和角分别构成相机和激光雷达鲁棒姿态估计的显著特征。

统一性,在此配置中,相机与相机、相机和激光雷达配置的标定均是支持。为了重建标定间的三维结构,我们使用低端立体相机捕捉其外观,并采用标准的运动结构(SfM)方法进行稀疏重建,实验证明,与工作中采用的高端扫描仪相比,这种低成本方法能够实现相当的重建精度。随后,我们能够在一次拍摄中有效地校准具有多个摄像头和激光雷达的系统的外参数据,并使用最先进的方法实现可比的校准精度。

在实验部分,我们通过多个具有不同传感器配置的设备验证了所提出的校准方法的准确性和效率,我们提出的方法甚至可以处理传感器不共享重叠区域的复杂且具有挑战性的情况,定量和定性结果表明,该方法的准确度与主流方法相当,而校准效率显著提高。

博主觉得这篇文章可以说是绝了!多个激光雷达和相机的快速且鲁棒的外参标定方法(代码开源)这篇文章的后续了,不同的是这里采用了单独有人工设计的标定间,思想是一致的。

主要内容

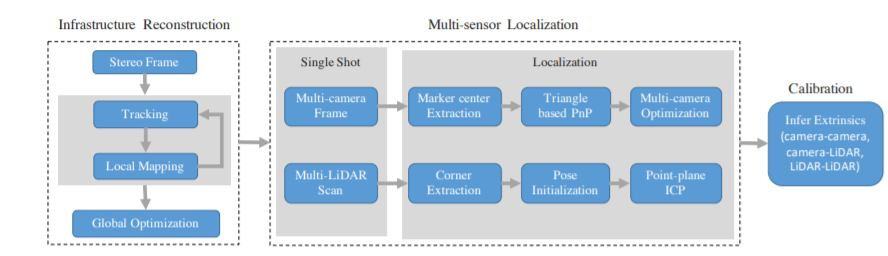

本文所提出的基于全景标定间的多传感器校准方法的框架如图2所示。在标定间重建过程中,使用标准增量双目SfM方法,获得标定房间的稀疏点云,这种稀疏重建作为后续校准过程的校准参考,基于重建的校准参考,只需对传感器数据进行一次扫描,包括多个摄像头和激光雷达,即可进行基于定位的校准。更具体地说,通过视觉匹配无特征基准标记,摄像机姿势在稀疏地图中定位,随后应用多个摄像机的联合优化,同样,我们通过几何特征(例如相对于相同稀疏重建的直线和点)定位激光雷达的姿态,最后,可以从任意两个传感器相对于校准基准的相应刚体变换推导出它们之间的相对姿态。

图2:本文提出的的基于全景标定间的多摄像机和3D激光雷达标定框架

A.全景标定间的重建

文章选择圆形标记物作为无特征基准标记,因为圆形标记的中心检测通常被认精度是比较高的,并且实验证明了圆形标记在校准精度方面优于AprilTags,为了重建全景标定间,提出了一种基于无特征基准标记物的立体SfM方法,该方法由立体视觉跟踪、局部建图和全局优化三个步骤组成。(双目的SFM,具有尺度,重建效果好)

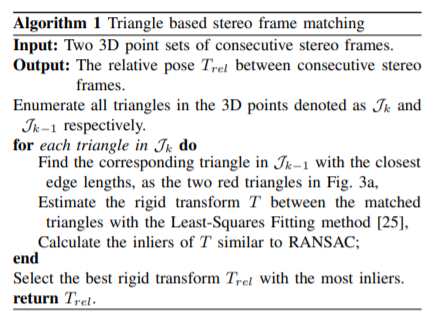

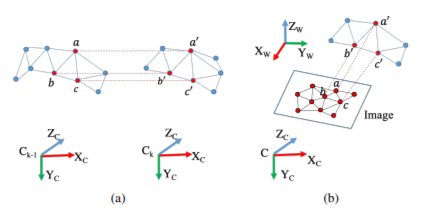

1) 立体帧跟踪:为了捕获连续的立体帧,需要平滑地移动立体摄像机以捕获720度的房间,与现有的双目SfM方法类似,左帧和右帧的无特征圆心均由检测圆形的标准方法检测,在双目相机的内、外参进行标定的前提下,通过标准极线搜索得到立体摄像机的特征对应关系,一旦左右帧之间建立了特征对应关系,就可以对相应的稀疏3D点进行三角剖分,为了在连续立体帧之间建立稀疏3D点的对应关系,文章提出了以下基于三角形的匹配算法,并在算法1中提供了详细信息。为了增加标定间重建的密度,特定立体帧的不匹配3D点仍保留在最终重建数据中。

2) 局部建图:在每次立体帧跟踪操作之后,提出一种环路闭合检测,以获得当前和先前立体帧之间更鲁棒的三维对应关系。回环检测的策略是将当前双目帧的稀疏点投影到在时间序列上远离当前双目帧的其他双目帧图像上。然后,检索与当前双目帧具有最多共可见稀疏点的立体帧,并通过执行算法1获得它们的匹配对应。

3) 全局优化:由于增量重建的结果会受到累积误差的影响,因此会应用束调整(BA)优化来同时优化所有摄影机姿势和稀疏点,并且将附近距离小于2cm的稀疏点合并为一个。

B.相机定位

一旦全景标定间的稀疏地图可用,我们就可以在单次拍摄中准确定位预先校准相机,首先,标定房间内每个摄像机的定位提供了多摄像机之间的初始参信息,然后,我们应用多个摄像机的几何约束,通过迭代Levenberg–Marquardt(LM)算法进一步优化外参,由于校准参考系中的基准标记没有特征,传统的视觉定位方法无法估计待校准多个摄像机的姿态,如图3b所示,与双目帧跟踪中引入的基于三角形的3D点匹配方法类似,我们可以克服图像和3D稀疏点都缺乏显著的基于纹理的特征,并将基于三角形的PnP与RANSAC算法相结合,以获得局部相机姿势。其步骤可分为四步:

1) 二维点的三角化

2) 三维点的三角化

3) 基于三角化的PnP

4) 多相机优化

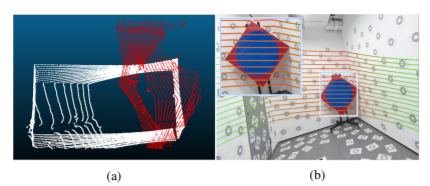

图3:通过三角化匹配的3D-3D和2D-3D特征对应匹配的视觉演示。(a) 双目帧跟踪中的3D-3D三角化匹配。(b) 摄像机定位中的2D-3D三角匹配示意图。

C.激光雷达定位

激光雷达的定位主要取决于房间内的几何信息,如重建点云中的空间线和角,这里,参考重建的角可以定义为4元组,分别为三条角线的方向向量,以及房间中的角点。对应的,由激光雷达采样的场景中也能检测到对应的角点和线。空间线和角点是三个墙面的交点,可通过平面拟合获得。

当激光雷达放置在标定间中时,激光雷达的大致方向是已知的,我们可以手动指定激光雷达和参考的标定间之间的空间线和角的对应关系,在获得参考系全景标定间和激光雷达之间方向不同的三条空间线和一个空间点的对应关系后,激光雷达扫描点云相对于校准基准的姿态可通过以下两个方程计算:

上述操作能够提供输入激光雷达扫描的粗略姿态,为了进一步优化输入激光雷达扫描的姿态,通过平面拟合的方式增采样全景标定间的稀疏重建的点云数据,并在激光雷达扫描点云和稠密的参考重建点云之间执行迭代最近点(ICP)优化位姿。对于参考的全景标定间,最终可获得了多个摄像机和激光雷达的局部姿态,推导出任意两个传感器之间的相对姿态就非常简单了。

这种基于重建的方法的优势是能够解决传感器没有或者较小的公共FOV外参标定,如此高投入的标定间也只有在大公司且量产较多的设备才会值得。

实验

为了评估所提出的方法的效率,我们在一台装有Intel i7-8700k的计算机上进行了所有实验,实验中采用了四种装置,如图4所示:

(a)立体摄像机(分辨率:1280×1024);

(b)地面激光扫描仪(TLS)由安装在伺服电机上的一个2D激光雷达和两个摄像头(分辨率:4608×3456)组成;

(c) 背包扫描仪,配备两个3D激光雷达和四个鱼眼摄像头(分辨率:2304×3840);

(d) 带有一个3D激光雷达和四个广角相机的移动机器人(分辨率:1280×720)。

图 4 实验中采用了四种装置

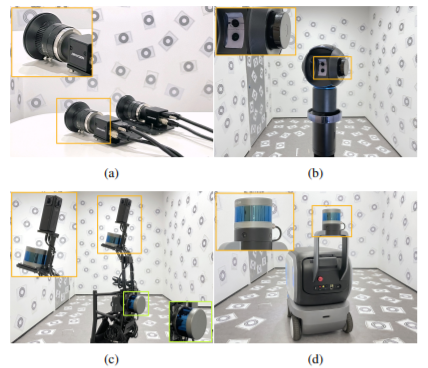

图5a所示为提出的立体SfM算法重建的全景地图点云地图,为了验证重建精度,引入了高端徕卡BLK3602来重建图5b所示的库房,捕获的密集点云具有高精度,可以视为真值(GT)

图5:标定间的重建:(a)立体SfM重建的全景地图点云,(b)徕卡BLK360重建的密集点云

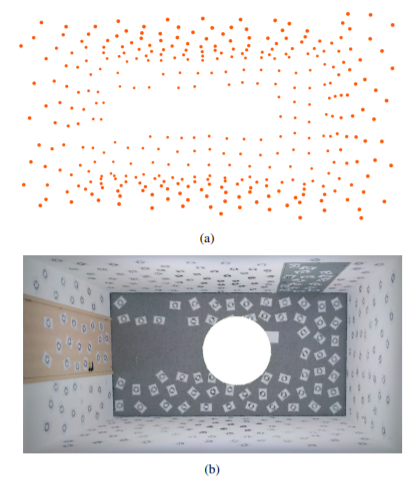

重建阶段使用的立体相机的校准结果,以及相应的重建精度

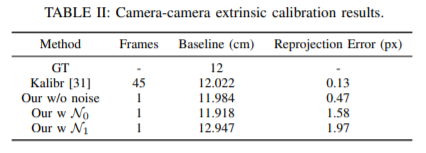

相机与相机外参的标定结果结果表明,所提出的方法仅使用一帧就可以达到与Kalibr相当的性能

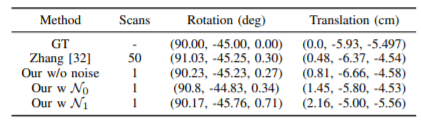

相机与激光雷达外参校准结果,旋转由绕XYZ的欧拉角表示,平移以XYZ的三个方向表示

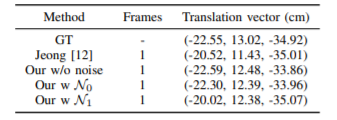

雷达之间的外参标定结果显示了我们的方法与之间方法的平移向量估计的比较。结果标定畸变有很少的FOV区域标定结果依旧表现出色。

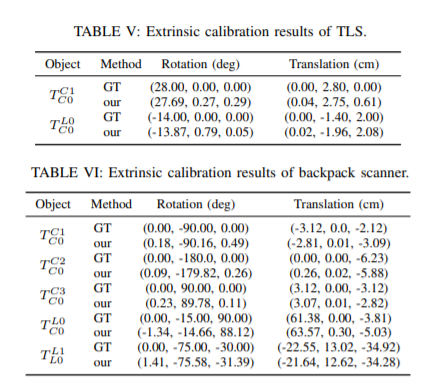

多传感器标定精度,这里设计了一系列实验,定性和定量地分析了多传感器标定精度的情况,为了验证,我们收集了不同的数据,包括三个配备了不同传感器套件的平台。对于每个平台,校准程序重复十次,并计算平均结果以进行鲁棒性分析。由于提供了三个平台的完整CAD图纸,我们将校准结果的旋转和平移与CAD图纸进行比较,后者被视为GT。旋转由绕XYZ的欧拉角表示,平移以XYZ的三个方向表示。

下图:背包扫描器外参校准结果:(a)为两个激光雷达扫描点云。(b) 激光雷达扫描外参投影到图像上。点的颜色因距离而异。

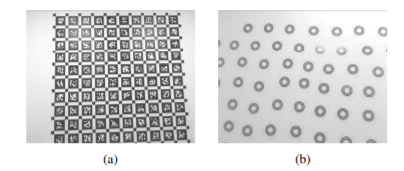

下图:从2米处捕获的标记物:(a)捕获的100个Apriltag标记。(b) 捕获了40个CCTAG。

对于标记选择,通过实验来比较CCTAG和AprilTags的校准精度,实验表明CCTAG在校准精度方面略优于AprilTags!!!

总结

在本文中,我们寻求一种高效的多传感器的外参标定的解决方案,该方案应涉及很少的操作,不需要专业知识,并适应多种摄像机和激光雷达的配置,为此,文章提出了一种基于全景标定间的单次采集的标定方法,该参考场景是经过精心设计,使得摄像机或激光雷达能够可靠地定位,从中可以导出传感器的相对变换。我们还提出了一种使用低端立体相机重建基础设施的经济方法,该方法可与昂贵的专业3D扫描仪(如徕卡BLK360)达到相当的精度。

A 局限性

激光雷达的定位仅依赖于3D扫描帧和重建标定间之间的ICP配准结果。如果激光雷达扫描不包含显著的几何特征,ICP匹配可能会失败,为了对窄视场激光雷达进行唯一定位,可以采取两种补救措施,首先,多个激光雷达应该通过成对的方法进行校准,然后它们的扫描组合成一个更大的扫描,这更有可能在基础设施中正确定位,第二,在标定房间内应增加几何特征,例如增加平面数量。

B 未来的工作

我们希望扩展我们的全景标定间,用于校准其他类型的传感器,例如cameraIMU(惯性测量单元)配置。此外,摄像机的内在参数也可以使用所提出的标定间与外在变换一起校准,我们还想检查在联合配置的传感器中优化相机和激光雷达的外部参数是否有益。

比如可以通过单帧图实现隔着玻璃的相机的内参再标定和优化,以及实现IMU与其他传感器的外参标定,十分期待了!!!,另外既然有开源代码,博主计划在后期对代码进行一些编译和记录,欢迎有兴趣的小伙伴一起学习!

资源

三维点云论文及相关应用分享

【点云论文速读】基于激光雷达的里程计及3D点云地图中的定位方法

3D目标检测:MV3D-Net

三维点云分割综述(上)

3D-MiniNet: 从点云中学习2D表示以实现快速有效的3D LIDAR语义分割(2020)

win下使用QT添加VTK插件实现点云可视化GUI

JSNet:3D点云的联合实例和语义分割

大场景三维点云的语义分割综述

PCL中outofcore模块---基于核外八叉树的大规模点云的显示

基于局部凹凸性进行目标分割

基于三维卷积神经网络的点云标记

点云的超体素(SuperVoxel)

基于超点图的大规模点云分割

更多文章可查看:点云学习历史文章大汇总

SLAM及AR相关分享

【开源方案共享】ORB-SLAM3开源啦!

【论文速读】AVP-SLAM:自动泊车系统中的语义SLAM

【点云论文速读】StructSLAM:结构化线特征SLAM

SLAM和AR综述

常用的3D深度相机

AR设备单目视觉惯导SLAM算法综述与评价

SLAM综述(4)激光与视觉融合SLAM

Kimera实时重建的语义SLAM系统

SLAM综述(3)-视觉与惯导,视觉与深度学习SLAM

易扩展的SLAM框架-OpenVSLAM

高翔:非结构化道路激光SLAM中的挑战

SLAM综述之Lidar SLAM

基于鱼眼相机的SLAM方法介绍

扫描下方微信视频号可查看最新研究成果及相关开源方案的演示:

如果你对本文感兴趣,请后台发送“知识星球”获取二维码,务必按照“姓名+学校/公司+研究方向”备注加入免费知识星球,免费下载pdf文档,和更多热爱分享的小伙伴一起交流吧!

以上内容如有错误请留言评论,欢迎指正交流。如有侵权,请联系删除

扫描二维码

关注我们

让我们一起分享一起学习吧!期待有想法,乐于分享的小伙伴加入免费星球注入爱分享的新鲜活力。分享的主题包含但不限于三维视觉,点云,高精地图,自动驾驶,以及机器人等相关的领域。

分享及合作方式:微信“920177957”(需要按要求备注) 联系邮箱:[email protected],欢迎企业来联系公众号展开合作。

点一下“在看”你会更好看耶

更多相关:

-

本文提出一种新颖的方法,可以对3D lidar和带有标定板的相机进行全自动的外参标定,提出的方法能够从lidar的每一帧点云数据中利用强度信息提取标定板的角点。通过激光的反射强度和棋盘格颜色之间的相关性的约束来优化将棋盘格分割的模型,所以一旦我们知道了3D 点云中棋盘的角点,那么两个传感器之间的外部校准就转换成了3D-2D的匹配问题。...

-

三 , ROS 环境下 如何进行相机标定 刚开始做到的时候遇到一些问题没有记录下来,现在回头写的时候都是没有错误的结果了,首先使用ROS标定相机, 要知道如何查看节点之间的流程图 rosrun rqt_graph rqt_graph ,如何查看我们运行的节点 rosnode list, 查看运行的话题...

-

一 、 理解摄像机模型,网上有很多讲解的十分详细,在这里我只是记录我的整合出来的资料和我的部分理解 计算机视觉领域中常见的三个坐标系:图像坐标系,相机坐标系,世界坐标系,实际上就是要用矩阵来表 示各个坐标系下的转换,首先在图像坐标系下与相机坐标系的关系 &nbs...

-

点云PCL免费知识星球,点云论文速读。文章:FAST-LIO2: Fast Direct LiDAR-inertial Odometry作者: Wei Xu∗1 , Yixi Cai∗1 , Dongjiao He1 , Jiarong Lin1 , Fu Zhang编译:点云PCL代码:https://github.com/hku...

-

点云PCL免费知识星球,点云论文速读。文章:Towards High-Performance Solid-State-LiDAR-Inertial Odometry and Mapping作者:Kailai Li, Meng Li, and Uwe D. Hanebeck编译:点云PCL代码:https://github.com/K...

-

论文阅读模块将分享点云处理,SLAM,三维视觉,高精地图相关的文章。公众号致力于理解三维视觉领域相关内容的干货分享,欢迎各位加入我,我们一起每天一篇文章阅读,开启分享之旅,有兴趣的可联系微信[email protected]。mlcc介绍本文主要实战应用这篇文章的代码,https://github.com/hku-mars/mlc...

-

标题:3D Vehicle Detection Using Camera and Low-Resolution LiDAR Zhang, Rui Huang, Le Cui, Siyu Zhu, and Ping Tan作者:Lin Bai, Yiming Zhao and Xinming Huang编译:点云PCL本文仅做学术分享...

-

标题:VCamVox: A Low-cost and Accurate Lidar-assisted Visual SLAM System作者:Yuewen Zhu, Chunran Zheng, Chongjian Yuan, Xu Huang and Xiaoping Hong来源:分享者代码:https://github.co...