SparkSQL和Hadoop(面向数据科学家和大数据分析师)

了解HDFS命令、Hadoop、Spark SQL、SQL查询、ETL和数据分析| Spark Hadoop集群虚拟机|完全解决的问题

你会学到什么

作为本课程的一部分,学生将获得在Spark Hadoop环境中工作的实践经验,该环境是免费且可下载的。

学生将有机会在沙箱环境中使用Hadoop集群上的Spark解决数据工程和数据分析问题

发布HDFS命令。

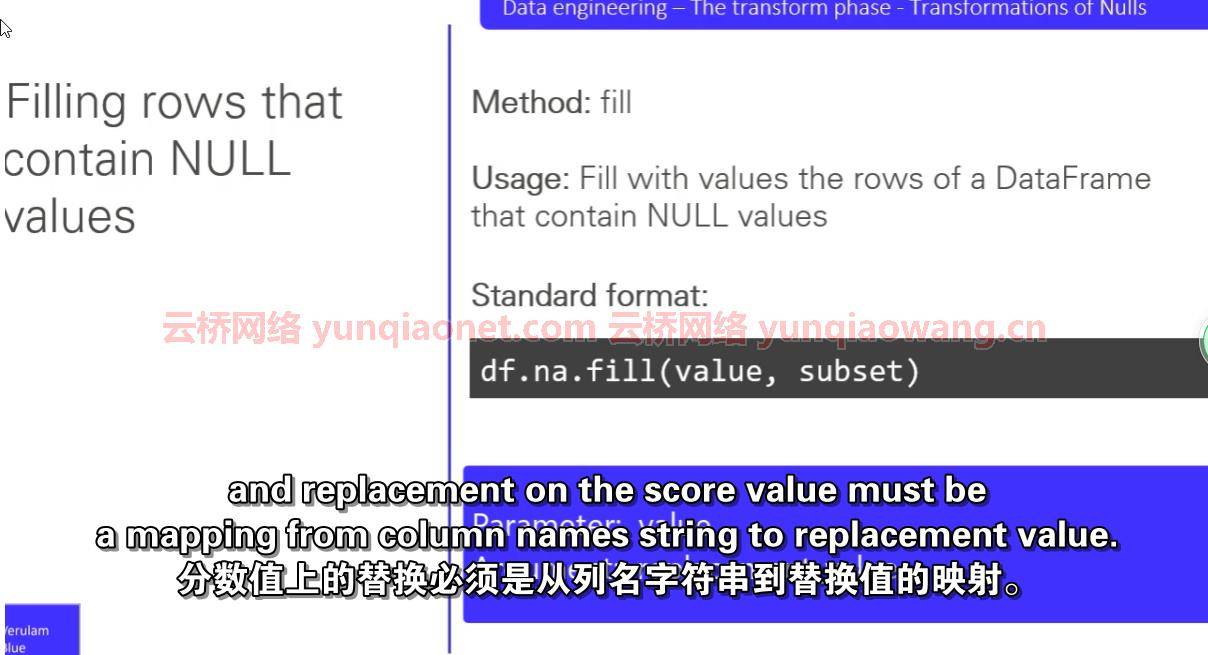

将存储在HDFS的一组给定格式的数据值转换为新的数据值或新的数据格式,并将其写入HDFS。

从HDFS加载数据用于Spark应用&使用Spark将结果写回HDFS。

以各种文件格式读写文件。

使用Spark API对数据执行标准的提取、转换、加载(ETL)过程。

使用metastore表作为Spark应用程序的输入源或输出接收器。

在Spark中应用查询数据集的基础知识。

使用Spark过滤数据。

编写计算聚合统计信息的查询。

使用Spark连接不同的数据集。

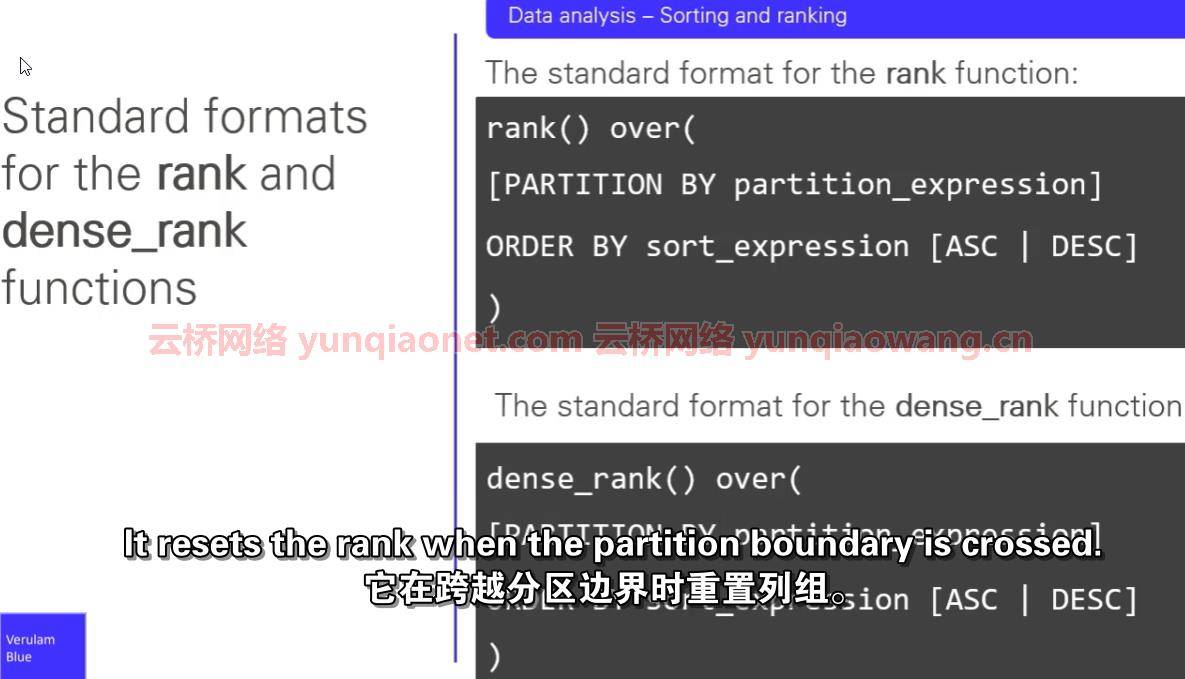

产生分级或分类的数据。

流派:电子学习| MP4 |视频:h264,1280×720 |音频:AAC,44.1 KHz

语言:英语+中英文字幕(根据原英文字幕机译更准确)|大小解压后:8..37GB 含课程文件 |时长:5h 37m

课程获取:SparkSQL和Hadoop(面向数据科学家和大数据分析师)_云桥网络

Spark SQL & Hadoop (For Data Scientists & Big Data Analysts)

描述

Apache Spark是目前最流行的大数据处理系统之一。

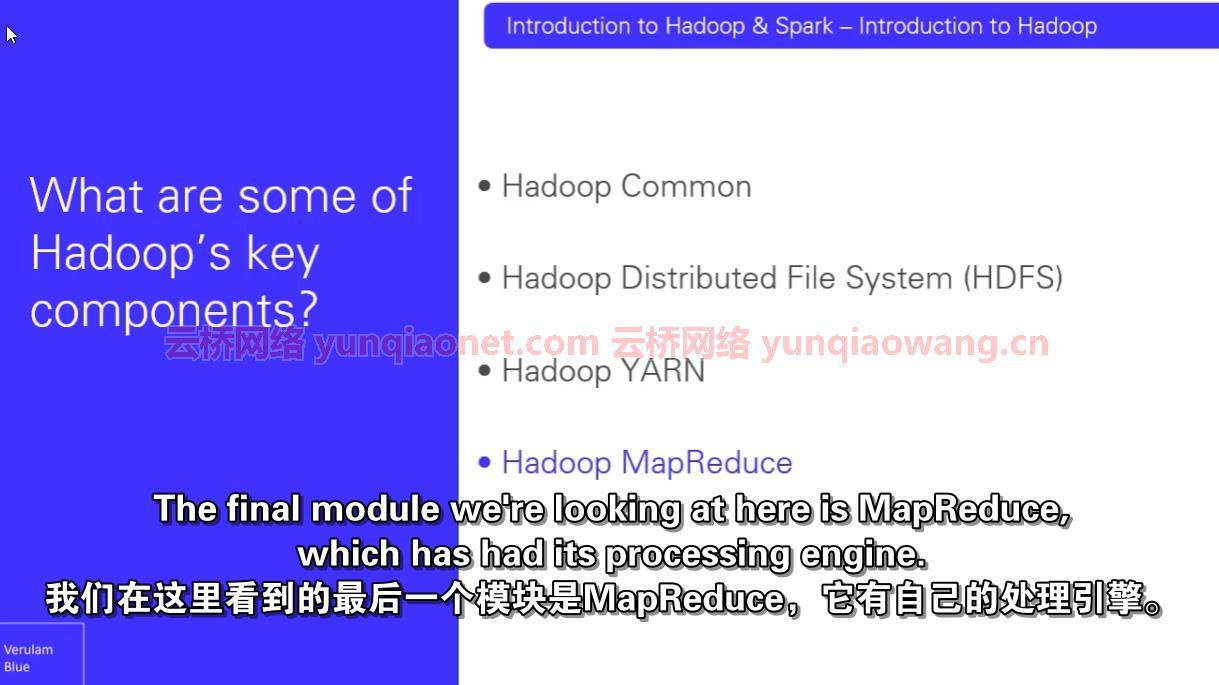

许多希望在本地存储数据的组织继续使用Apache Hadoop。Hadoop允许这些组织高效地存储从千兆字节到千兆字节的大数据集。

随着数据科学、大数据分析和数据工程职位空缺数量的持续增长,对具备Spark和Hadoop技术知识的个人填补这些空缺的需求也将持续增长。

本课程专为希望利用Hadoop和Apache Spark的力量来理解大数据的数据科学家、大数据分析师和数据工程师设计。

本课程将帮助那些希望交互式分析大数据或开始编写生产应用程序的人准备数据,以便在Hadoop环境中使用火花SQL进行进一步分析。

该课程也非常适合希望接触Spark & Hadoop的大学生和应届毕业生,或者只想在使用Spark-SQL的大数据环境中应用自己的SQL技能的任何人。

本课程旨在简明扼要,并为学生提供必要和足够的理论,足以让他们能够使用Hadoop & Spark,而不会陷入太多关于RDDs等旧的低级APIs的理论。

在解决本课程中包含的问题时,学生将开始发展这些技能&处理生产环境中出现的真实场景所需的信心。

(一)这门课程的问题不到30个。这些包括hdfs命令、基本数据工程任务和数据分析。

全面解决所有问题。

(c)还包括Verulam Blue虚拟机,这是一个已经安装了spark Hadoop集群的环境,以便您可以练习解决问题。

该虚拟机包含一个Spark Hadoop环境,该环境允许学生读写Hadoop文件系统中的数据,并将元存储表存储在Hive元存储上。

学生解决问题所需的所有数据集都已经加载到HDFS上,所以学生不需要做任何额外的工作。

虚拟机还安装了阿帕奇齐柏林飞艇。这是一款专门针对Spark的笔记本,类似于Python的Jupyter笔记本。

本课程将允许学生在实践过程中获得在Spark Hadoop环境中工作的实践经验

将存储在HDFS的一组给定格式的数据值转换为新的数据值或新的数据格式,并将其写入HDFS。

从HDFS加载数据用于Spark应用&使用Spark将结果写回HDFS。

以各种文件格式读写文件。

使用Spark API对数据执行标准的提取、转换、加载(ETL)过程。

使用metastore表作为Spark应用程序的输入源或输出接收器。

在Spark中应用查询数据集的基础知识。

使用Spark过滤数据。

编写计算聚合统计信息的查询。

使用Spark连接不同的数据集。

产生分级或分类的数据。

这门课是给谁的

本课程专为希望利用Hadoop和Apache Spark的力量来理解大数据的数据科学家、大数据分析师和数据工程师设计。

这门课程也非常适合大学生和刚毕业的学生,他们渴望在一家希望填补大数据相关职位的公司找到工作,或者任何只想在使用Spark-SQL的大数据环境中应用他们的SQL技能的人。

希望进入数据工程领域的软件工程师和开发人员也会发现本课程很有帮助。

更多相关:

-

本文是西门子开放式TCP通信的第2篇,上一篇我们讲了使用西门子1200PLC作为TCP服务器的程序编写,可以点击下方链接阅读:【公众号dotNet工控上位机:thinger_swj】基于Socket访问西门子PLC系列教程(一)在完成上述步骤后,接下来就是编写上位机软件与PLC之间进行通信。上位机UI界面设计如下图所示:从上图可以看出...

-

我有一个大型数据集,列出了在全国不同地区销售的竞争对手产品。我希望通过使用这些新数据帧名称中的列值的迭代过程,根据区域将该数据帧分成几个其他区域,以便我可以分别处理每个数据帧-例如根据价格对每个地区的信息进行排序,以了解每个地区的市场情况。我给出了以下数据的简化版本:Competitor Region ProductA Product...

-

作为一名IT从业者,我来回答一下这个问题。首先,对于具有Java编程基础的人来说,学习Python的初期并不会遇到太大的障碍,但是要结合自己的发展规划来制定学习规划,尤其要重视学习方向的选择。Java与Python都是比较典型的全场景编程语言,相比于Java语言来说,当前Python语言在大数据、人工智能领域的应用更为广泛一些,而且大...

-

这段时间通过学习相关的知识,最大的变化就是看待事物更加喜欢去了解事物后面的本质,碰到问题后解决问题思路也发生了改变。举个具体的例子,我在学习数据分析,将来会考虑从事这方面的工作,需要掌握的相关专业知识这个问题暂且按下不表,那哪些具体的问题是我需要了解的呢,以下简单罗列:1、了解数据分析师这个岗位在各个地区的需求情况?2、数据分析师的薪...

-

这一节将开始学习python的一个核心数据分析支持库---pandas,它是python数据分析实践与实战的必备高级工具。对于使用 Python 进行数据分析来说,pandas 几乎是无人不知,无人不晓的。今天,我们就来认识认识数据分析界鼎鼎大名的 pandas。目录一. pandas主要数据结构 SeriesDataFrame二...

-

Configuration spark-env.sh HADOOP_CONF_DIR=/opt/data02/hadoop-2.6.0-cdh5.4.0/etc/hadoop JAVA_HOME=/opt/modules/jdk1.7.0_67 SCALA_HOME=/opt/modul...

-

不多说,直接上干货! SparkSQL 与 Spark Core的关系 Spark SQL构建在Spark Core之上,专门用来处理结构化数据(不仅仅是SQL)。 Spark SQL在Spark Core的基础上针对结构化数据处理进行很多优化和改进, 简单来讲: Spark SQL 支持很多种...

-

我们很荣幸能够见证Hadoop十年从无到有,再到称王。感动于技术的日新月异时,希望通过这篇内容深入解读Hadoop的昨天、今天和明天,憧憬下一个十年。 本文分为技术篇、产业篇、应用篇、展望篇四部分 技术篇 2006年项目成立的一开始,“Hadoop”这个单词只代表了两个组件——HDFS和MapReduce。到现在...

-

很多人只会,但没深入体会和想为什么要这样? 拿Hadoop来说,当然,spark也一样的道理。 输出路径由Hadoop自己创建,实际的结果文件遵守part-nnnn的约定。 如何指定一个已有目录作为Hadoop作业的输出路径,作业将无法进行,并会抛出异常抗议一个已经存在的目录。如果想让Hadoop将输出存储到一个目录,...

-

http://blog.itpub.net/26978437/viewspace-730136/ 按照上几篇的内容,安装好两台ubuntu虚拟机之后,首先确定好哪台机子做namenode,哪台做datanode,打开终端,输入:$sudo vi /etc/hosts 在打开的文件中输入主机名和IP地址,比如我的是: 127.0.0....

-

关键词:Ubuntu;hadoop; 注意:开始这一步之前,需安装Oracle的jdk,参见: http://www.cnblogs.com/fengfengqingqingyangyang/archive/2012/11/06/2756981.html 1、下载hadoop的合适版本:http://labs.mop.com/apa...